脳波であなたの好きな音楽がわかる?感情を読むAIが進化中

日々耳にするお気に入りの音楽。実はその一曲一曲が、私たちの気分や感情にさまざまな影響を与えています。明るいメロディに元気づけられたり、切ない旋律に心が動かされた経験は誰しもあるでしょう。

こうした音楽が引き起こす感情を、脳波(EEG)から読み取る研究が今、注目を集めています。

今回はICASSP 2025で発表された論文「Multimodal Fusion for EEG Emotion Recognition in Music」を取り上げ、大規模言語モデル(LLM)やマルチタスク学習を用いて、従来を大きく上回る感情認識を実現した最新研究をご紹介します。

音楽を聴いたときの「気持ち」を脳波で読み取る難しさ

音楽を聴いて感じる気持ちを脳波から読み取る研究は、近年少しずつ進んできましたが、このような研究の中で大きなハードルとなるのが、「音楽の感じ方に個人差がある」という点です。

同じ曲を聴いても、人によって感じる気持ちが違いますし、それに伴う脳波の反応も変わってきます。このばらつきが、AIが感情を正しく読み取るうえで障壁となってきました。

これまでの多くの研究では、さまざまな人の脳波データをひとつにまとめてAIに学ばせるという方法が取られてきました。しかしこの方法では、誰が聴いたかという違いが考慮されないため、個人差を無視したままAIが学習してしまうという課題がありました。

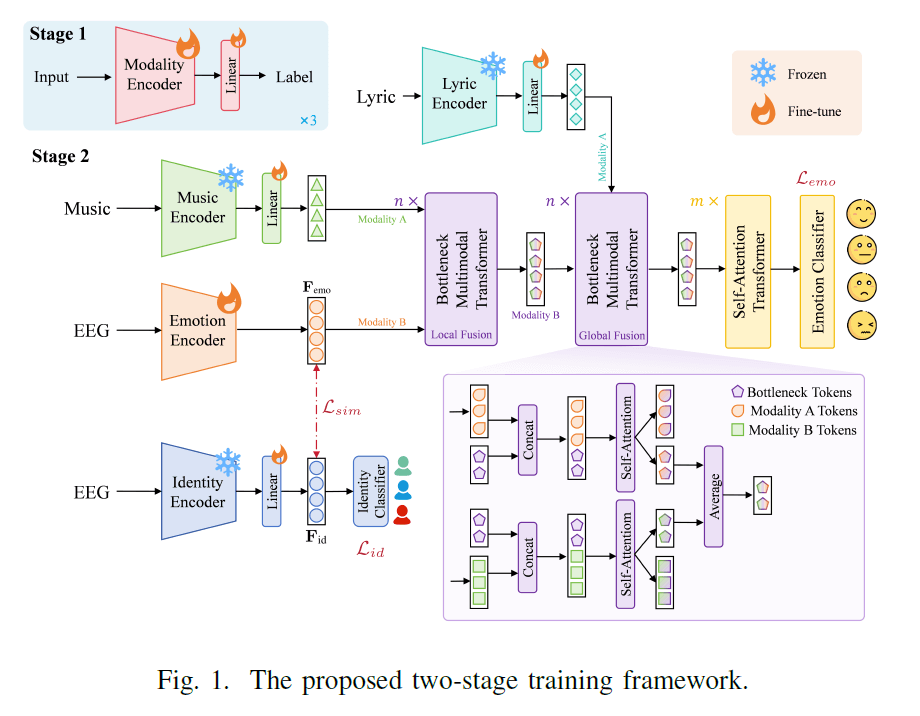

そこで本研究では、感情を読み取るだけでなく、聴き手が誰なのかを識別するタスクも同時にAIに学ばせる手法が採用されました。このように複数の目的を同時に学ばせることで、AIは人ごとの特徴を踏まえたうえで、より正確に感情を読み取れるようになります。

さらに本研究では、感情を「うれしい」「悲しい」といった単純な分類ではなく、「どれくらい明るい気分か(Valence)」と「どれくらい興奮しているか(Arousal)」という2つの軸に分けて数値で表すことで、より細やかな感情の変化まで見えるようになりました。

音楽の印象を手がかりに、AIが感情を読み解く

脳波だけで感情を読み取ろうとすると、人によって反応が違うため、どうしても限界があります。そこで今回の研究では、脳波だけでなく、音楽そのものの情報も一緒にAIに学ばせるという新しいアプローチがとられました。

人が音楽を聴いて感情を動かされるとき、そのきっかけはメロディやリズム、テンポ、音の明るさや暗さといった曲の特徴です。つまり、「どんな音楽か」と「脳がどう反応したか」を合わせて見ることで、感情の変化をより正確にとらえることができるのです。

さらにこの研究では、音楽の感情的な特徴を読み取るために、大規模言語モデル(LLM)が活用されました。

LLMとは、ChatGPTのようなAIの一種で、大量の言語情報をもとに意味を理解することができます。このモデルを使うことで、「この曲は明るくてエネルギッシュ」「この曲は静かで物悲しい」といった音楽の雰囲気や印象をAIが言葉から読み取り、その特徴を数値として扱うことができるようになります。

こうして得られた音楽の特徴と、聴いたときの脳波の変化の両方をAIが一緒に学ぶことで、どちらか一方だけでは読み取りきれなかった感情の手がかりをつかむことができるようになりました。

出典:Huang, S., Jin, Z., Li, D., Han, J., & Tao, X. (2025). Multimodal Fusion for EEG Emotion Recognition in Music with a Multi-Task Learning Framework. 2025 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP)

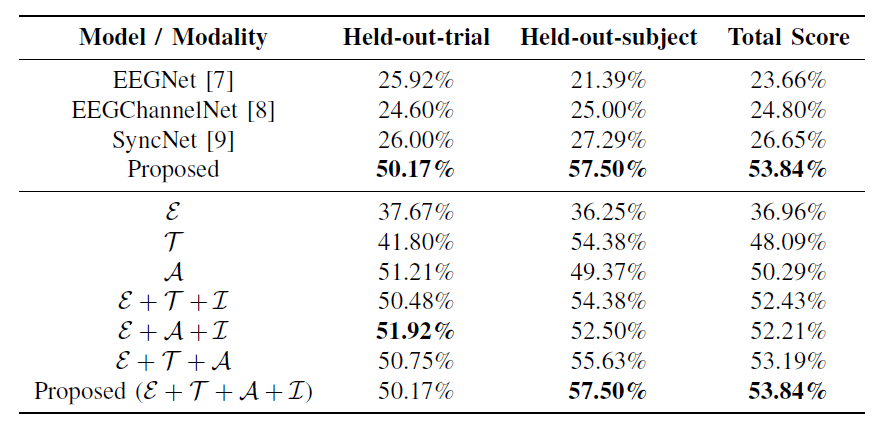

ベースラインを大きく上回る精度向上

こうした工夫により、今回の研究では従来の手法を大きく上回る精度で感情を推定することに成功しました。

音楽の印象と脳波のデータを組み合わせ、さらに聴き手の情報まで取り入れたことで、AIはより正確に「その人が音楽を聴いてどう感じたか」を読み取れるようになったのです。

また、感情を2つの軸で表すことにより、「なんとなく楽しい」「少し不安」といった曖昧な気持ちも、数値として扱うことが可能になりました。

AIはそうした微妙な感情の揺れまで捉えられるようになり、結果として精度の向上につながりました。

今回の結果は、単に技術的なブレイクスルーというだけでなく、人の“心の動き”を読み取るAIの進化を感じさせるものでもあります。

音楽という主観的で感覚的なものを、客観的な脳波と融合しながら扱えるようになったことは、今後のブレインテックの広がりにとっても大きな意味を持つでしょう。

出典:Huang, S., Jin, Z., Li, D., Han, J., & Tao, X. (2025). Multimodal Fusion for EEG Emotion Recognition in Music with a Multi-Task Learning Framework. 2025 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP)

脳波が拓くパーソナライズ音楽推薦の未来

こうした技術は、単なる感情の分析にとどまらず、私たちの日常に活かされる可能性を秘めています。とくに注目されているのが、音楽推薦システムへの応用です。

これまでも、「この曲が好きそう」「前に聴いたジャンルからおすすめ」といったレコメンド機能は存在していましたが、そこには“そのときの気分”という要素までは反映されていませんでした。

今回の研究のように、脳波を通してリアルタイムで感情を読み取れるようになれば、今の自分にぴったりの音楽を自動で選んでくれる世界が見えてきます。

たとえば、疲れているときにはリラックスできる曲を、集中したいときにはテンポのいい曲を提案するような、状況や気分に合わせた音楽体験が可能になるのです。

さらに将来的には、ストレス状態の検出やメンタルヘルスへの応用も期待されています。

脳波によって感情の変化を客観的にモニタリングできれば、「最近落ち込みがちだな」といった心のサインを早期に察知し、音楽を通じてやさしく気分を整えるような介入も夢ではありません。

脳と音楽とAIがつながることで、「今の気分にぴったりな音楽」を自動で選んでくれるような体験――そんな未来が、少しずつ現実になってきています。

🧠 編集後記|BrainTech Magazineより

「この曲、今の気分にぴったり」と感じたこと、きっと誰にでもあるはずです。

その“気分”が脳波とAIで読み取れるようになってきているなんて、ちょっとワクワクしますよね。

今回ご紹介した研究は、話題の大規模言語モデルやマルチタスク学習といった最新技術を巧みに活用し、個人差の壁を越えながら、より自然で柔軟な感情理解に挑んだ点が非常に印象的でした。

今後、音楽推薦やメンタルヘルスといった分野での応用が進めば、「今の自分に寄り添う音楽体験」が、誰にとってもあたりまえのものになるかもしれません。

BrainTech Magazineでは、こうした脳科学とテクノロジーの交差点から生まれる最前線の研究を、今後もわかりやすくお届けしていきます。

Huang, S., Jin, Z., Li, D., Han, J., & Tao, X. (2025). Multimodal Fusion for EEG Emotion Recognition in Music with a Multi-Task Learning Framework. 2025 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP).

WRITER

NeuroTech Magazine編集部

BrainTech Magazine編集部のアカウントです。

運営するVIE株式会社は、「Live Connected, Feel the Life~」をミッションに、ニューロテクノロジーとエンターテイメントで、感性に満ちた豊かな社会をつくることをサポートするプロダクトを創造することで、ウェルビーイングに貢献し、さらに、脳神経に関わる未来の医療ICT・デジタルセラピューティクスの発展にも寄与していきます。

一覧ページへ戻る