脳でタイピング?Meta最新研究が示す非侵襲BCIの可能性

スマートフォンを操作せずに、考えたことがそのまま文字になるとしたら────まるでSFのような話ですが、近年この夢に一歩近づく研究が登場しています。Facebook改めMeta社では、2017年頃から「脳でタイピングする」技術開発に意欲を見せてきました1。

そしてついに2025年、Metaの研究チームは非侵襲型ブレイン・コンピュータ・インターフェース(BCI)で、脳活動からテキストを解読することに成功したと発表しました2。これは、脳に電極を埋め込むことなく、脳波などの信号を使って、頭の中で思い浮かべた文章を読み取ろうとする技術です。

この技術は、コミュニケーションが困難な人々への支援につながる可能性があるほか、将来的には誰もが使える「パーソナルBCI」としての応用も期待されています。この記事では、そんな注目の研究成果をわかりやすくご紹介します。

研究の概要:非侵襲BCIで脳活動から文字を入力

Meta社の研究論文『Brain-to-Text Decoding: A Non-invasive Approach via Typing』では、Brain2Qwertyと名付けられたAIモデルを使い、脳活動から直接テキストを生成する実験が報告されています。この方法の最大の特徴は「非侵襲的」であることです。

従来、BCIで高精度に脳信号を解読するには、脳に電極を埋め込む手術が必要でした。しかし本研究では、頭皮上の電極で脳の電気信号を計測するEEG(Electroencephalography、脳波計測)や、頭部を覆う装置で脳磁場を測定するMEG(Magnetoencephalography、脳磁気計測)といった、非侵襲的な計測だけで脳内の「タイピング信号」を読み取っています。

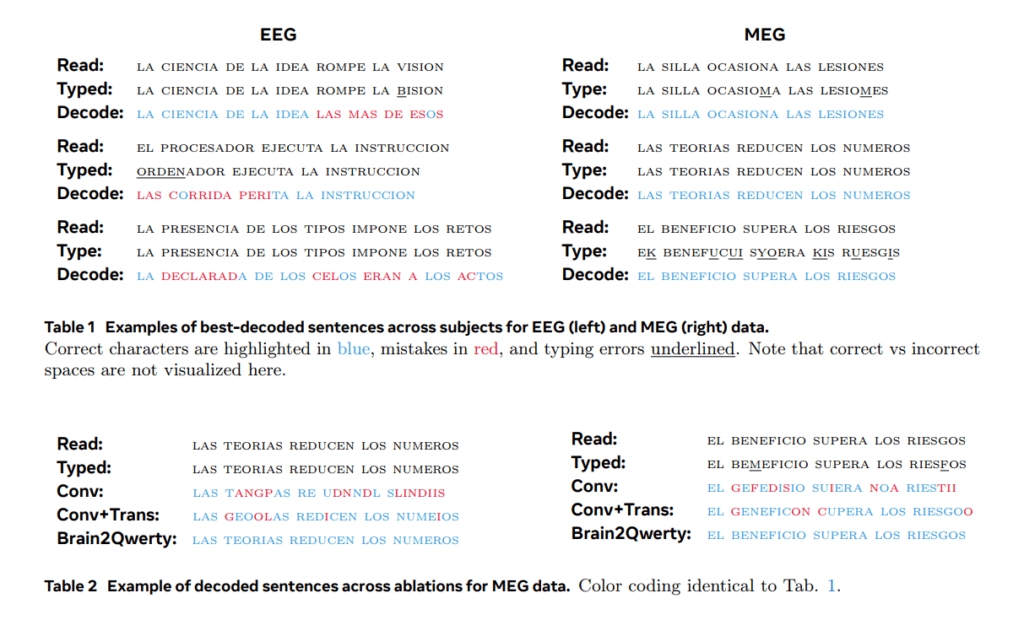

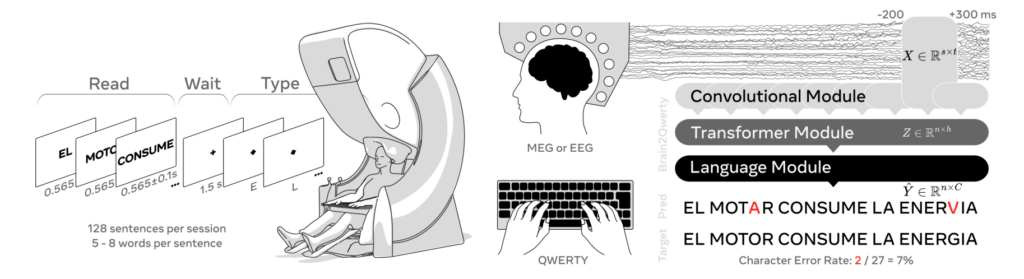

実験には35人の健康なボランティアが参加しました。被験者にはまず、画面に表示されたスペイン語の短い文(5〜8語程度)を覚えてもらい、その文をキーボードで入力してもらいます。ただし、入力中は画面に文字が表示されず、自分が何を打っているのかは見えない状態でした。この間の脳活動(EEGやMEG)を記録し、そのデータからAIが入力しようとしている文をどこまで正確に読み取れるかを検証しました。

MEGとEEGでの解読結果──「考えた文章」をどこまで再現できたか?

実験の結果、脳磁気計測(MEG)を使った場合、AIモデル「Brain2Qwerty」は平均で文字の誤り率32%という結果になりました。つまり、全体の約68%の文字を正しく読み取ることができたのです。

さらに、誤り率が19%=約8割の文字を正しく解読できた参加者もおり、そのレベルでは、AIが学習していない新しい文章でも、正確に再現できたと報告されています。

出典:Lévy, J., López-Cózar, C., Sharifian, F., et al. (2025). Brain-to-Text Decoding: A Non-invasive Approach via Typing. arXiv preprint.

、一方、脳波(EEG)だけを使った場合は、文字の誤り率が約30%にとどまり、約70%の文字を正しく読み取ることができました。これは、MEGの精度には及ばないものの、非侵襲BCIとしては非常に高い成果であり、今後の研究の大きな一歩となります。

技術の仕組み:EEGとAIで「タイピングの意思」を読み解く

どうやって脳波から文字を当てることができるのか? 一見すると、どのような仕組みでそんなことができるのか、不思議に思う方もいるかもしれません。Brain2Qwertyのポイントは、脳が文字をタイプするときに生じるパターンをAIが学習し、それをもとに入力された文章を推測するしくみにあります。

人がキーボードで文を入力するとき、脳内では「次にどのキーを押すか」といった運動の指令や、思い浮かべた文章を整理し、言葉にするような認知的な処理が行われています。研究チームは、これらの脳信号のわずかな変化を捉えるため、前述のEEGやMEGで0.5秒ごとの脳活動を切り出して解析しました。この信号データを解読するAIモデルがBrain2Qwertyの正体なのです。

Brain2Qwertyの内部は、最新のディープラーニング技術を駆使した3つのモジュールから成ります:

- 畳み込みニューラルネットワーク(CNN)モジュール :

脳波の生データから特徴を抽出し、0.5秒(500ミリ秒)単位の短い時間窓で信号パターンを捉え、脳活動の微細な変化をとらえます。 - トランスフォーマーモジュール :

タイピング中の脳活動の時間的な変化を分析し、「どの文字が入力されているか」を予測する役割を担います。前後の文脈も同時に捉えられるため、文章全体の流れをふまえた精度の高い予測が可能です。 - 言語モデルモジュール :

スペイン語の文章データで事前学習された文字レベルの言語モデルで、AIが予測した文字列を補正します。直近の9文字分の文脈から次の文字の確率を計算し、トランスフォーマーの予測結果と組み合わせて、自然な文章に整えま。いわば自動スペルチェックのような働きで、脳信号由来の誤認識を言語的な観点から修正してくれます。

このように脳信号処理+深層学習+言語の知識を統合することで、Brain2Qwertyは被験者が頭の中で思い浮かべ、タイピングしている文章を解読することができるのです。

出典:Lévy, J., López-Cózar, C., Sharifian, F., et al. (2025). Brain-to-Text Decoding: A Non-invasive Approach via Typing. arXiv preprint.

面白いことに、研究チームの分析によれば、解読は純粋に指の動き(運動信号)だけに依存しているわけではなく、キーボード配列の影響やタイピングミスといった、頭の中で考えていることや判断のクセも含まれている可能性もあることが分かりました。つまり、脳内で文章を組み立て、キーを押す一連のプロセス全体をモデルが学習しており、単なる運動読み取り以上のことが起きているようなのです。

非侵襲BCIがもたらすコミュニケーション支援

この研究が注目される理由の一つは、言葉や身体を失った人々の新たなコミュニケーション手段につながる可能性です。近年、脳卒中や神経変性疾患で話す力を失った人に対して、脳内に電極を埋め込む侵襲型BCIを使い、文字や音声でのコミュニケーションを取り戻す研究が進んでいます。

たとえば、2021年には脳にセンサーを埋め込んで、頭の中で思い描いた文字を読み取り、1分間に約90文字も入力できたという研究が報告されています3。また2023年には、脳の表面に埋め込んだ皮質電極を通じて、考えた言葉をそのまま音声に変換し、ほぼ普通に話せるレベルの精度で「声を出す」ことに成功した研究も発表されています4。

しかし、こうした最先端のコミュニケーション補助は、センサーや電極を脳に埋め込む手術が必要であり、大きなリスクとコストを伴います。

そこで期待されるのが、非侵襲BCIによるコミュニケーション支援です。今回のMetaの成果は、自動補完や反復による訂正ができれば、80%近い文字精度でも意味の通る文章を伝えることは可能です。実際、外科手術は難しい高齢のALS(筋萎縮性側索硬化症)患者や重度の麻痺患者にとって、脳に傷をつけないコミュニケーションBCIは、人生を変える可能性を秘めています。

今回のBrain2Qwertyはまだ研究段階ですが、将来的にこれを応用した装置が開発されれば、声や動きが失われた人々に再び言葉を取り戻す手段を提供できるかもしれません。

🧠 編集後記|BrainTech Magazineより

脳からの信号を読み取り、言葉として再構成する──かつて困難とされてきた課題に、非侵襲の手法で挑んだ今回の研究は、今後のBCI開発に向けた貴重な一歩となりました。まだ実用化には距離があるものの、これまで見えにくかった脳とテクノロジーの接点が、確かに輪郭を持ちはじめています。

📝 本記事で紹介した研究論文

Lévy, J., López-Cózar, C., Sharifian, F., et al. (2025). Brain-to-Text Decoding: A Non-invasive Approach via Typing. arXiv preprint.

- Facebook(2017年4月19日). 開発者カンファレンス「F8」2017:2日目発表内容まとめ. Retrieved from https://about.fb.com/ja/news/2017/04/f8-2017-day-2/ ↩︎

- Meta AI. (2025年2月7日). Using AI to decode language from the brain and advance our understanding of human communication. Meta. https://ai.meta.com/blog/brain-ai-research-human-communication/ ↩︎

- Willett, F. R., Avansino, D. T., Hochberg, L. R., Henderson, J. M., & Shenoy, K. V. (2021). High-performance brain-to-text communication via handwriting. Nature, 593(7858), 249–254. https://www.nature.com/articles/s41586-021-03506-2 ↩︎

- Metzger, S. L., Littlejohn, K. T., Silva, A. B., Moses, D. A., Seaton, M. P., Wang, R., Dougherty, M. E., Liu, J. R., Wu, P., Berger, M. A., Zhuravleva, I., Tu-Chan, A., Ganguly, K., Anumanchipalli, G. K., & Chang, E. F. (2023). A high-performance neuroprosthesis for speech decoding and avatar control. Nature, 620(7976), 1037–1046. https://www.nature.com/articles/s41586-023-06443-4

↩︎

WRITER

NeuroTech Magazine編集部

BrainTech Magazine編集部のアカウントです。

運営するVIE株式会社は、「Live Connected, Feel the Life~」をミッションに、ニューロテクノロジーとエンターテイメントで、感性に満ちた豊かな社会をつくることをサポートするプロダクトを創造することで、ウェルビーイングに貢献し、さらに、脳神経に関わる未来の医療ICT・デジタルセラピューティクスの発展にも寄与していきます。

一覧ページへ戻る